Le marché des serveurs d’intelligence artificielle (IA) et de calcul haute performance est en pleine effervescence, avec Nvidia en tête grâce à ses GPU de pointe. Cependant, des rumeurs récentes suggèrent que les GPU Blackwell de nouvelle génération, les B100 et B200, pourraient subir des retards significatifs. Selon Charles Liang, directeur général de Supermicro, ces retards n’auront toutefois pas de répercussions majeures sur les fabricants de serveurs d’IA.

Nvidia et les GPU Blackwell : Un Défi Technologique

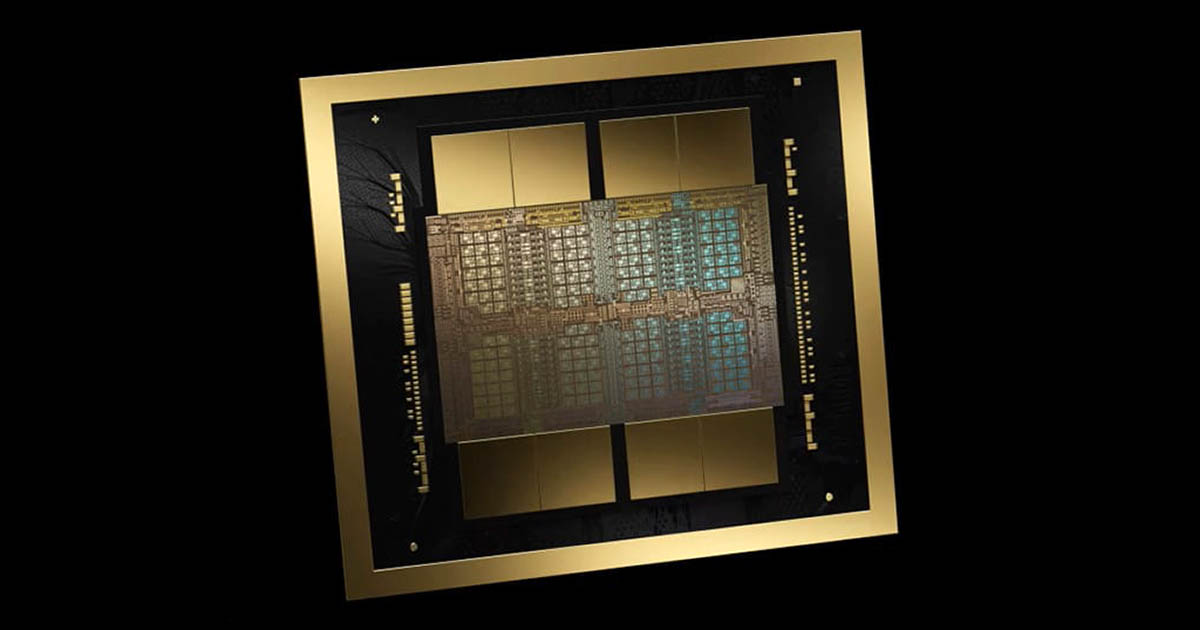

Les GPU Blackwell de Nvidia, notamment les modèles B100 et B200, sont cruciaux pour les applications d’IA et de calcul haute performance. Ces GPU sont les premiers à utiliser le boîtier CoWoS-L de TSMC avec un interposeur Super Carrier, une avancée technologique permettant de construire des systèmes en boîtier jusqu’à six fois la taille du réticule standard. Cette architecture unique utilise des ponts d’interconnexion locale en silicium (LSI) intégrés dans un interposeur de couche de redistribution (RDL), remplaçant l’interposeur en silicium traditionnel utilisé dans les GPU H100.

Cependant, cette innovation s’accompagne de défis importants. Selon les analystes de SemiAnalysis, un problème de conception pourrait résider dans l’incompatibilité du coefficient de dilatation thermique (CTE) entre les différentes composantes du GPU, notamment les puces, les ponts LSI, l’interposeur RDL, et le substrat de la carte mère. Ce problème pourrait entraîner une déformation et une défaillance du système en boîtier (SiP), nécessitant une refonte des matrices de pont et des couches métalliques de routage globales.

Supermicro : Une Attitude Résiliente Face aux Retards

Malgré ces complications, Supermicro reste optimiste quant à l’impact des retards de Nvidia. Charles Liang a déclaré que ces retards, bien que regrettables, sont une réalité dans le domaine des nouvelles technologies. Il a souligné que Supermicro est bien préparé à fournir des solutions alternatives à ses clients, notamment avec des systèmes de refroidissement liquide avancés comme le H200.

“Nous avons entendu dire que Nvidia pourrait avoir du retard, et nous considérons cela comme une possibilité normale”, a déclaré Liang lors de la conférence téléphonique sur les résultats de Supermicro. Il a ajouté que ce retard ne devrait pas avoir un impact global majeur sur le marché, rassurant ainsi les investisseurs et les partenaires.

L’Avenir des GPU Blackwell et le Marché des Serveurs d’IA

Malgré les retards, Nvidia prévoit de produire en faibles volumes les GPU B200 de 1 000 W au quatrième trimestre 2024, en partie à cause de la capacité limitée du CoWoS-L et des problèmes de conception. Des serveurs haut de gamme basés sur le GPU B200 de 1 200 W seront également disponibles, bien que de manière limitée.

Pour répondre à la demande croissante de systèmes d’IA de milieu de gamme, Nvidia travaille également sur une version alternative du B200, le B200A, qui utilise un silicium monolithique B102 avec 144 Go de mémoire HBM3E. Ce modèle est attendu pour le deuxième trimestre 2025 et sera disponible dans des formats de 700 W et 1 000 W.

Enfin, selon SemiAnalysis, Nvidia prépare une mise à niveau de mi-génération de la série Blackwell, surnommée Blackwell Ultra, qui inclura des améliorations significatives en termes de mémoire et de performances.

En dépit des retards potentiels dans la production des GPU Blackwell, Supermicro et Nvidia restent des acteurs clés dans le secteur des serveurs d’IA. Les innovations technologiques de Nvidia, telles que les GPU B100 et B200, continuent de représenter une avancée majeure dans le domaine du calcul haute performance. Le marché des serveurs d’IA, bien que potentiellement affecté à court terme, devrait bénéficier à long terme des nouvelles solutions que Nvidia et Supermicro sont prêts à offrir.

Nvidia, avec ses GPU de la série RTX 5000, continue de renforcer sa position en tant que leader du marché, et ces retards, bien qu’inhérents au développement de nouvelles technologies, ne devraient pas entraver la progression globale du marché des serveurs d’IA.

source